Serverlose Analyse in Echtzeit

In unserer modernen Welt erzeugen verschiedenste Geräten und Sensoren immer mehr Daten. Daher wird es immer wichtiger diese Daten in Echtzeit auszuwerten. Mit Azure Stream Analytics integrieren Sie Ihre IoT-Geräte und -Anwendungen mit geringem Aufwand in eine Stream Analytics-Engine. Mit dessen Hilfe kann man Echtzeit Analysen auf den Daten ausführen. So erlangen Sie jederzeit neue Erkenntnisse über Ihre Daten und können entsprechend reagieren.

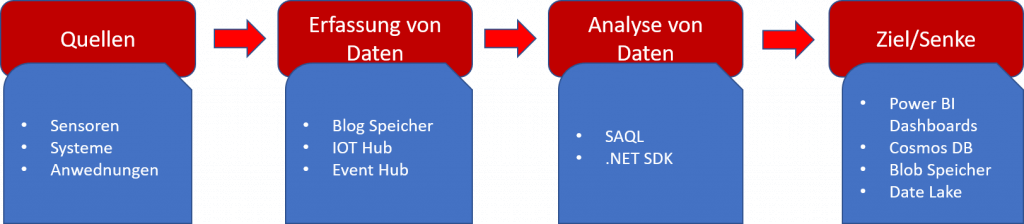

Eine typische Pipeline basierend auf Stream Analytics besteht

aus 4 Komponenten

Ereignisersteller

Ein Ereignisersteller ist eine Anwendung, ein System oder ein Sensor, der kontinuierlich relevante Ereignisdaten erzeugt. Als Beispiel wollen wir einen Sensor in einem Parkhaus betrachten. Dieser misst den Zustand des Stellplatzes und leitet die Ergebnisse zu einer beliebigen Anwendung weiter. Folglich kann dann dort eingesehen werden, ob der Stellplatz noch frei ist oder nicht.

Ereigniserfassungssystem

Dieses „System“ ruft die Daten aus dem Quellsystem ab und übergibt die Daten an die Analyse-Engine. Azure Stream Analytics kann dabei Daten von verschiedenen Erfassungssystemen verarbeiten. Im Speziellen sind das:

- der Azure Event Hub,

- der Azure IoT Hub,

- sowie der Azure Blob Storage

Stream Analytics-Engine

Hier erfolgt die Berechnung über die eingehenden Datenströme. Somit kann man in Echtzeit neue Erkenntnisse ermitteln. Mit Azure Stream Analytics ist die Stream Analytics-Abfragesprache (SAQL) verfügbar, die auf Transact-SQL basiert. Diese Sprache ist auf die Durchführung von Berechnungen über Streaming-Daten optimiert.

Ereigniskonsument

Hierbei handelt es sich um das Ziel (Senke), in dem die gewonnen Erkenntnisse abgelegt werden. Das Ziel kann ein Speicher (Azure Data Lake, Cosmos DB, SQL Azure oder Azure Blob Storage) sein. Ebenso möglich ist aber auch beispielsweise ein von Power BI unterstütztes Dashboard.

Da es sich bei den Azure Stream Analytics um einen PaaS-Dienst handelt, wird dieser vollständig verwaltet und läuft somit äußerst zuverlässig. Des Weiterenkann man die Pipeline für komplexere Szenarien mit benutzerdefiniertem Code und integrierten Machine-Learning-Funktionen erweitern.

Sie möchten sich intensiver mit dem Thema Stream Analytics befassen? Dann sind die herzlich eingeladen sich mit uns in Verbindung zu setzen.